Q1/2024: Rộn ràng cơn sốt LLM

Trong quý 1 năm 2024, một loạt các mô hình ngôn ngữ lớn (LLM) đã ra mắt các phiên bản cập nhật mới nhất với khả năng mạnh mẽ và ấn tượng hơn. Một tín hiệu cho thấy việc sử dụng LLM sẽ trở nên phổ biến hơn trong tương lai.

Chỉ trong 3 tháng đầu năm 2024, giới công nghệ chứng kiến sự bùng nổ mạnh mẽ của AI, len lỏi vào mọi ngóc ngách của đời sống. Nhu cầu này ngày càng tăng cao, từ các tập đoàn lớn đến các startup đều đổ xô vào nghiên cứu, phát triển và ứng dụng AI.

Các mô hình ngôn ngữ lớn (LLM)

Quý 1 năm 2024 ghi nhận hàng loạt cập nhật mới nhất về công nghệ AI. Các nhà nghiên cứu liên tục cho ra mắt những mô hình AI tiên tiến với khả năng xử lý thông tin và giải quyết vấn đề ngày càng phức tạp.

Gemini 1.5 là mô hình AI thế hệ mới được phát triển bởi Google AI, ra mắt vào tháng 2/2024. Gemini 1.5 mang đến hiệu năng xử lý mạnh mẽ hơn nhiều so với các phiên bản trước. Điều này đạt được nhờ những cải tiến và đổi mới trong toàn bộ quá trình phát triển, từ nghiên cứu thuật toán đến xây dựng cơ sở hạ tầng. Một điểm nhấn đáng chú ý là việc sử dụng kiến trúc Mixture-of-Experts (MoE) giúp Gemini 1.5 tiết kiệm chi phí huấn luyện và vận hành. Gemini 1.5 Pro sở hữu tính năng đặc biệt - hiểu ngữ cảnh dài, cụ thể là tới 1 triệu token. Điều này cho phép model xử lý và phân tích các đoạn văn bản, đoạn hội thoại hoặc chuỗi sự kiện kéo dài, giúp đưa ra câu trả lời chính xác và toàn diện hơn.

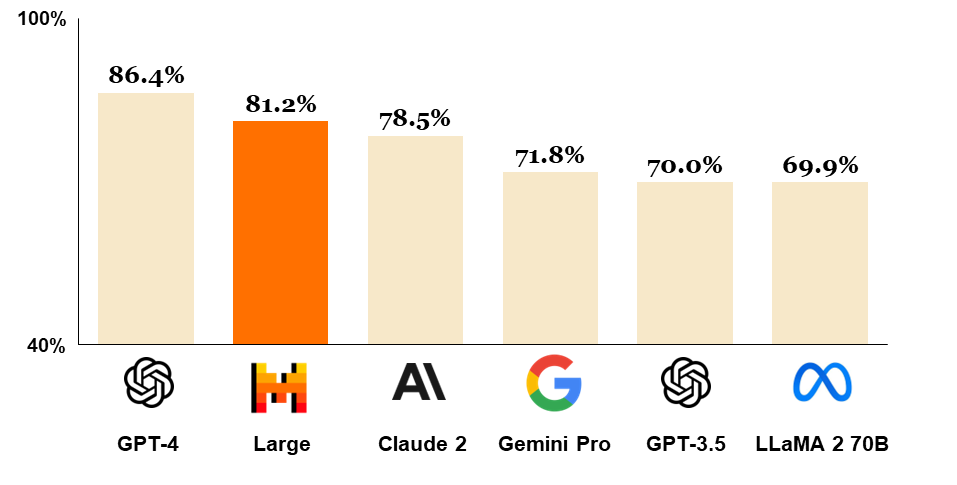

Cũng ra mắt vào tháng 2, Mistral Au Large có khả năng giải quyết các tác vụ đa ngôn ngữ phức tạp, bao gồm hiểu văn bản, chuyển đổi văn bản và tạo mã. Khách hàng có thể sử dụng Mistral Large để xây dựng các cuộc hội thoại trôi chảy, tạo nội dung tinh tế và xử lý các tác vụ logic phức tạp. Ngoài ra, thế mạnh của mô hình này còn mở rộng sang lĩnh vực lập trình, với khả năng tạo, đánh giá và bình luận mã nguồn trên các ngôn ngữ lập trình phổ biến. Mistral Large có khả năng sử dụng thành thạo tiếng Anh, Pháp, Tây Ban Nha, Đức và Ý, đồng thời hiểu sâu sắc về ngữ pháp và văn hóa của các ngôn ngữ này. Về kỹ thuật, Mistral Au Large hỗ trợ 32k context window cho phép xử lý văn bản lớn dễ dàng hơn. Mistral Au Large cũng đạt kết quả rất cao trong các bài kiểm tra.

Nguồn: Mistral AI

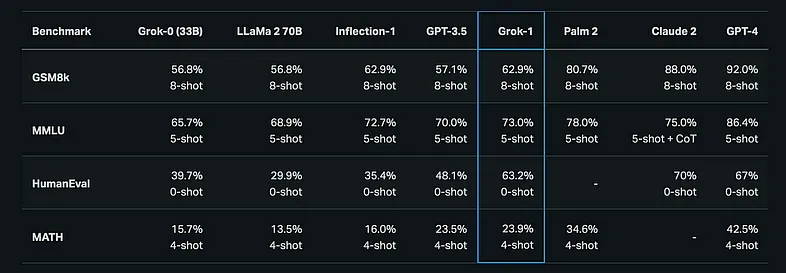

Không nằm ngoài cuộc đua, Elon Musk cũng ra mắt Grok vào tháng 3. Với số lượng tham số khổng lồ lên tới 314 tỉ, kích thước của model cũng khổng lồ và cần có cấu hình cực mạnh để chạy được model. X cung cấp miễn phí model trên github. Kết quả của Grok cũng rất tốt. Tuy nhiên với kích thước khổng lồ hoặc chỉ người dùng trả tiền của X mới được sử dụng nên việc tiếp cận Grok ít nhiều khó khăn.

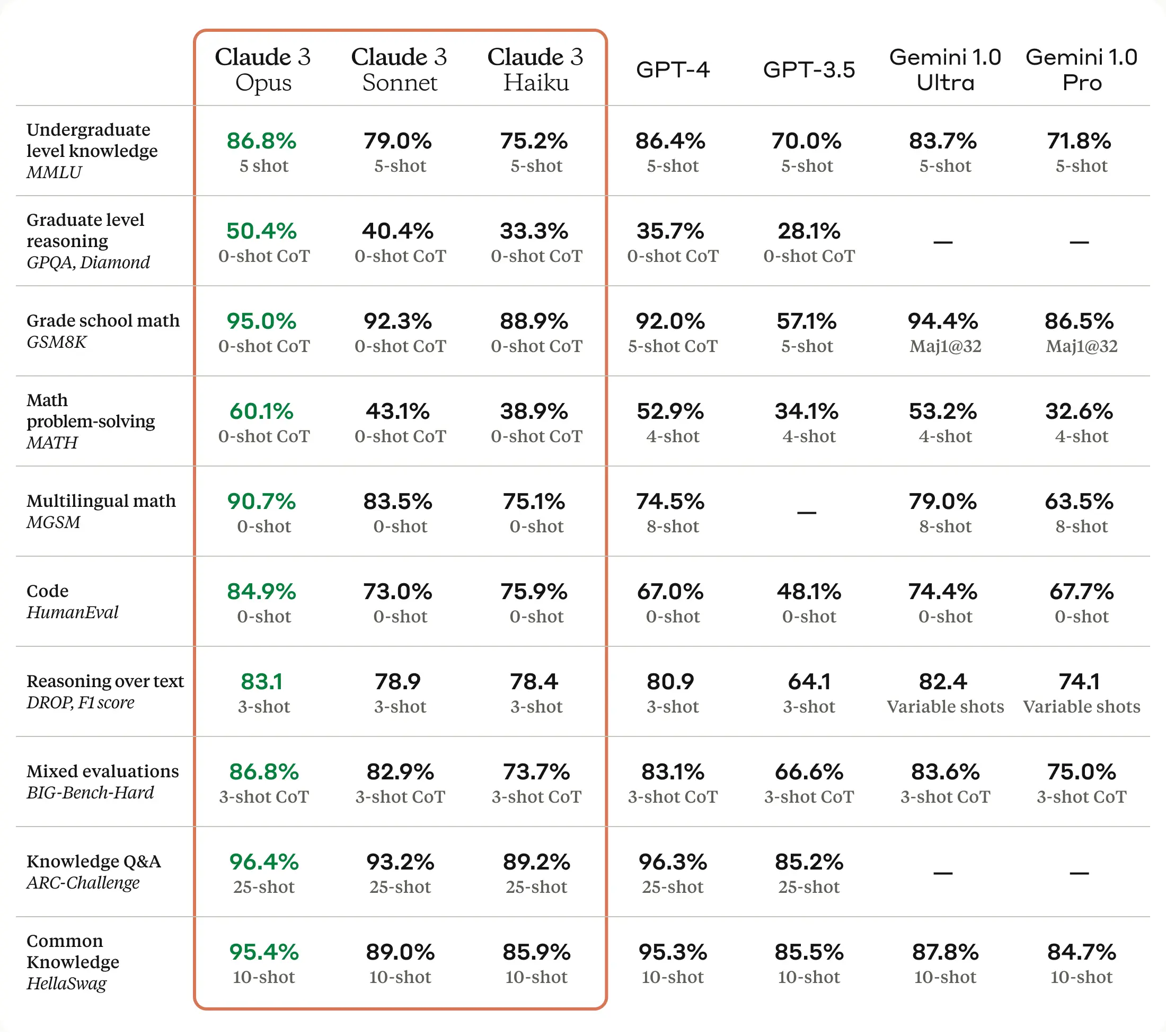

Ngoài các model kể trên, chúng ta cũng phải nhắc đến Claude AI. Model Claude 3 chạy nhanh hơn và có kết quả tốt hơn GPT-4 trên tất cả các bài kiểm tra với chữ và cả hình ảnh. Claude 3 hỗ trợ 200k token và cho phép tối đa lên tới 1 triệu token giúp cho người dùng có thể tận dụng để đưa các nội dung rất dài cho Claude 3 xử lý.

Người dùng có thể sử dụng miễn phí Claude AI, tuy nhiên bạn cần email và số điện thoại để đăng ký.

Bên cạnh những mô hình AI mới, các phương thức triển khai và ứng dụng AI cũng có nhiều bước tiến đáng kể. Các công cụ và nền tảng AI ngày càng dễ sử dụng, giúp cho việc triển khai AI trở nên đơn giản và hiệu quả hơn. Nhờ vậy, AI không còn là "lãnh địa" riêng của các chuyên gia mà dần trở nên phổ biến với mọi đối tượng.

Nếu như ở giai đoạn beta, kĩ sư phải xin một loạt giấy phép mới được tiếp cận mô hình LLM, giờ đây các nhà cung cấp dịch vụ đám mây như Azure, AWS, Google đã khá thoáng với việc cho phép triển khai LLM. Bên cạnh các hãng đám mây này thì cũng xuất hiện nhiều các doanh nghiệp chỉ chuyên cung cấp dịch vụ LLM như Claude, Groq… giúp cho việc tiếp cận cực kỳ dễ dàng với chi phí hợp lý.

Không đứng ngoài cuộc đua, Databricks cũng cung cấp mô hình của riêng mình mang tên DBRX, đi kèm một loạt dịch vụ cho việc triển khai LLM trong chỉ 3 tháng đầu năm 2024. Có thể kể đến như Vector Search cho phép tạo trực tiếp vector index trên DeltaTable, đào tạo mô hình trực tiếp trong luồng xử lý giúp việc tinh chỉnh mô hình trở nên cực kỳ dễ dàng với kỹ sư dữ liệu, quản lý mô hình (MLOps) ngay trong Databricks. Ngoài ra, Databricks còn cung cấp các mô hình triển khai tiêu chuẩn, hay hướng dẫn triển khai RAG (Retrieval Augmented Generation - Tạo tăng cường truy xuất) với Databricks một cách dễ dàng. Tóm lại, bạn có thể áp dụng hầu như tất cả mô hình ngôn ngữ lớn và các kỹ thuật triển khai chỉ bằng cách dùng mỗi Databricks.

Xây dựng và tối ưu AI

RAG và Fine-tune là 2 chủ đề được nhắc đến nhiều nhất, cả hai kỹ thuật đều đóng vai trò quan trọng trong việc cải thiện hiệu suất và độ tin cậy của các mô hình AI tạo sinh. RAG cung cấp cho LLM quyền truy cập vào kiến thức bên ngoài, trong khi Fine Tuning giúp chúng học hỏi các tác vụ cụ thể. Khi được sử dụng kết hợp, hai kỹ thuật này có thể giúp tạo ra các mô hình AI mạnh mẽ và linh hoạt hơn.

Và trong năm 2024, việc áp dụng RAG + Fine-tune trở nên cực kỳ dễ dàng. Đầu tiên có thể kể đến LangChain - một framework nổi tiếng mà hầu như ai quan tâm AI cũng biết. Xem thêm loạt bài về LangChain tại đây.

Tập trung vào việc cải thiện độ chính xác bằng RAG, Llamaindex liên tục đưa ra các agents mới cho phép developer chỉ cần dùng LlamaIndex nhưng vẫn dễ dàng tích hợp dữ liệu riêng tư vào LLM như Gemini, GPT-3 và GPT-4. LlamaIndex giúp các mô hình này truy cập và xử lý dữ liệu riêng tư một cách an toàn và hiệu quả, cho phép tạo ra các ứng dụng thông minh và hữu ích hơn. Bạn chỉ cần vào các ví dụ đã được cung cấp sẵn là sẽ có hướng dẫn từng bước một để xây dựng ứng AI cho riêng mình với tất cả các kỹ thuật tiên tiến.

Để xây dựng RAG, một thành phần không thể thiếu là cơ sở dữ liệu Vector, lúc này bạn cứ yên tâm là sẽ có vô vàn lựa chọn. Sau bản preview được công bố vào cuối năm 2023, vào tháng 2 năm nay, Redis đã chính thức hỗ trợ vector đồng thời cung cấp thư viện Redis Vector Library cho phép dễ dàng embedding từ dữ liệu đang có trong Redis và tìm kiếm chỉ với vài dòng code. Việc này cũng giúp các nhà cung cấp dịch vụ đám mây cho phép người dùng triển khai trên dịch vụ của họ một cách nhanh chóng, ví dụ như Memorystore của GCP, Amazon MemoryDB for Redis hay Azure Cache for Redis…

Dĩ nhiên là còn hàng loạt các giải pháp khác, tuy nhiên do đã ra mắt vào cuối 2023, nên không xin phép nhắc đến ở đây.

Triển khai LLM là một quá trình phức tạp nhưng mang lại nhiều lợi ích. Tuy nhiên, sự phát triển của các công cụ và framework đã giúp việc triển khai LLM trở nên dễ dàng hơn bao giờ hết. Các nhà phát triển không cần phải có kiến thức chuyên môn cao về NLP để sử dụng LLM cho các ứng dụng của họ. Với sự phát triển nhanh chóng của LLM, chúng ta có thể mong đợi rằng việc sử dụng LLM sẽ trở nên phổ biến hơn trong tương lai. LLM có tiềm năng thay đổi cách chúng ta tương tác với máy tính, đồng thời giúp chúng ta thực hiện các công việc một cách hiệu quả và sáng tạo hơn.